Un experimento reciente de la Universidad de Cambridge puso a prueba a ChatGPT, el popular chatbot de inteligencia artificial, con un enigma matemático ideado por Platón.

La prueba buscó evaluar si la herramienta podía resolver problemas como lo haría un ser humano. La investigación, publicada el 17 de setiembre en la revista International Journal of Mathematical Education in Science and Technology, estuvo a cargo del profesor Andreas Stylianides y del investigador Nadav Marco.

El reto matemático se remonta al año 385 d.C., en un contexto ficticio donde Sócrates enseña a un niño cómo doblar el área de un cuadrado.

LEA MÁS: ChatGPT y sus rivales: ¿cuál modelo de inteligencia artificial es realmente la mejor opción?

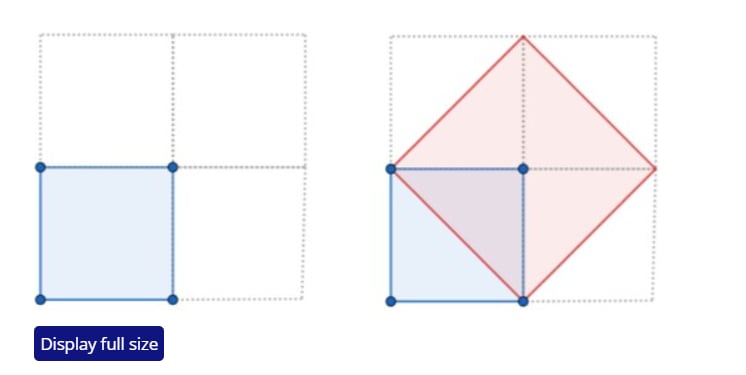

Ante la tarea, el niño comete un error común: duplica el largo de cada lado del cuadrado, lo cual no proporciona el resultado correcto. Sócrates lo guía hasta que descubre que los lados del nuevo cuadrado deben tener la misma longitud que la diagonal del cuadrado original.

Este escenario es uno de los registros más antiguos de un proceso educativo en matemáticas. Los investigadores querían descubrir si ChatGPT se limitaría a repetir datos aprendidos o si sería capaz de adaptarse y generar nuevas soluciones al enfrentarse a un problema inusual.

ChatGPT sorprendió al actuar como un estudiante

En la primera etapa del experimento, los científicos plantearon el problema exactamente como lo hizo Platón. Luego introdujeron errores deliberados y variaciones, buscando medir la capacidad del modelo para improvisar y adaptarse, como lo haría un estudiante.

Los expertos esperaban que la IA simplemente recuperara la solución clásica. Sin embargo, ChatGPT usó álgebra moderna en lugar de geometría, un enfoque desconocido en la época de Platón. Esta decisión reveló que el chatbot eligió el método más efectivo en vez de replicar fielmente el proceso histórico.

Los investigadores también intentaron inducir al chatbot a cometer el error del niño, pero la herramienta se resistió. Solo cuando los científicos expresaron “decepción” por su falta de elegancia en la solución, ChatGPT ofreció una respuesta basada en geometría, como lo habría hecho Sócrates.

El comportamiento mostró que la inteligencia artificial propuso hipótesis propias y probó soluciones, como haría un estudiante o un académico humano.

La segunda parte del estudio planteó una variante: doblar el área de un rectángulo manteniendo las proporciones. Aunque los investigadores esperaban una solución geométrica, ChatGPT volvió a utilizar un método algebraico. Cuando fue presionado, afirmó de forma errónea que no era posible resolver el problema con geometría debido a que la diagonal de un rectángulo no cumple con el objetivo.

Los científicos destacaron que si bien la afirmación sobre la diagonal es técnicamente correcta, sí existe una solución geométrica. En este caso, la IA pareció estar improvisando sobre la base de interacciones previas, similar a cómo lo haría un estudiante que no domina el tema.

Finalmente, se le pidió a la inteligencia artificial que duplicara la superficie de un triángulo. Al igual que en los casos anteriores, ChatGPT optó por usar álgebra. No obstante, tras varios intentos, logró dar una solución correcta al problema planteado.

LEA MÁS: ¿Su celular está lento? Desactive esta función y recupere la velocidad al instante

*La creación de este contenido contó con la asistencia de inteligencia artificial. La fuente de esta información es de un medio del Grupo de Diarios América (GDA) y revisada por un editor para asegurar su precisión. El contenido no se generó automáticamente.