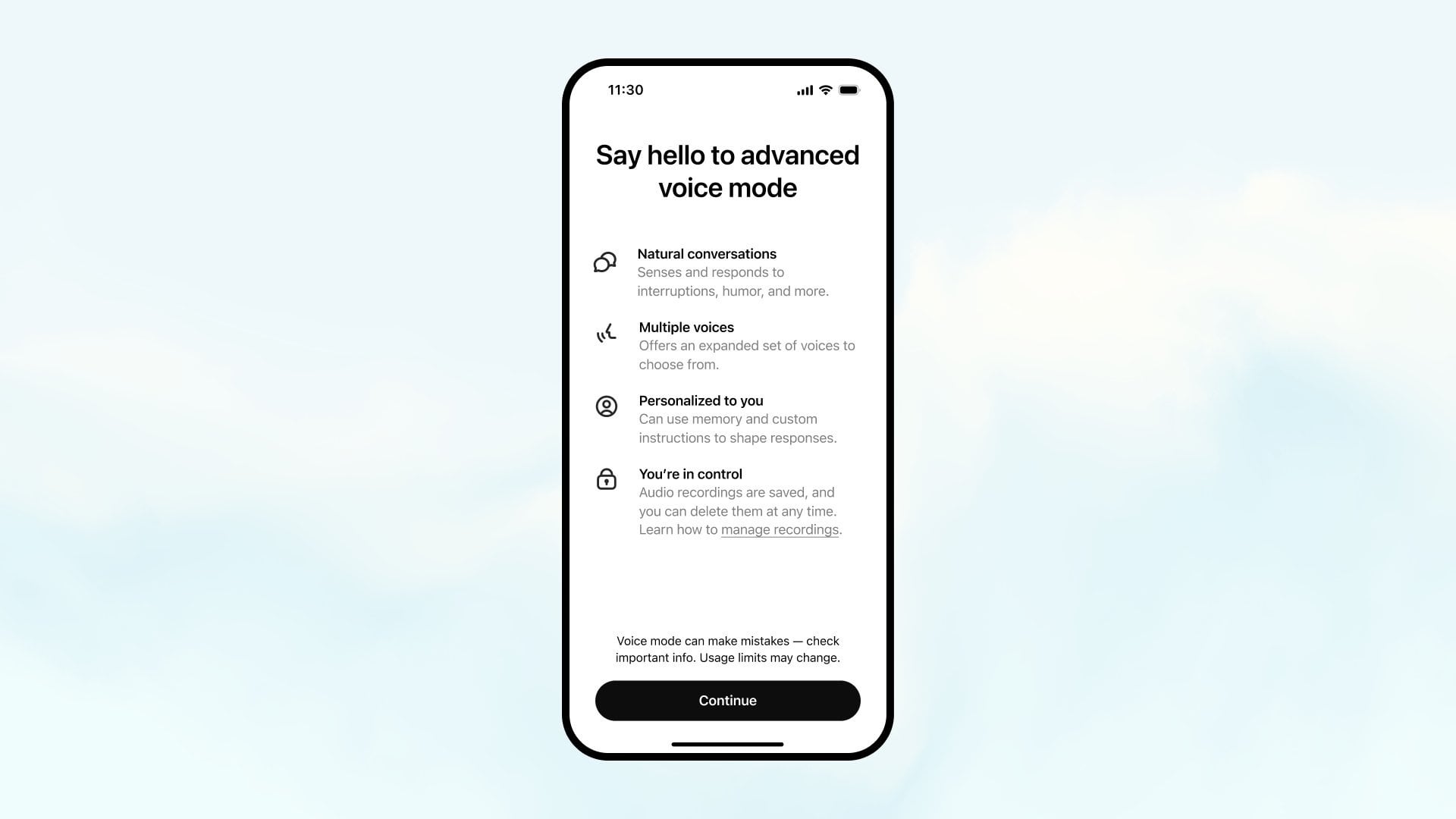

OpenAI comenzó a desplegar el modo de voz avanzado para los usuarios de ChatGPT Plus y Team, ofreciendo una interacción más fluida con la inteligencia artificial (IA). Esta nueva función permite a los usuarios conversar en tiempo real con la IA, incluyendo el uso de voces personalizadas y la capacidad de transmitir emociones y señales no verbales.

El anuncio del lanzamiento se realizó a través de X. OpenAI detalló que el modo de voz incluye cinco nuevas voces llamadas Arbor, Maple, Sol, Spruce y Vale, además de mejoras en las ya existentes Breeze, Juniper, Cove y Ember. Sin embargo, la voz de Sky, utilizada en demostraciones previas, no está disponible debido a una controversia por su similitud con la voz de la actriz Scarlett Johansson, quien ya había dado vida a un asistente de IA en la película Her.

LEA MÁS: ¿Qué ofrece el nuevo modo de voz avanzado de ChatGPT Plus?

Este modo de voz avanzado debía ser lanzado en julio para un grupo selecto de usuarios, pero fue pospuesto para asegurar el cumplimiento de altos estándares de seguridad. No obstante, desde ese mes, una versión alfa estuvo disponible para algunos suscriptores de ChatGPT Plus.

Junto a las nuevas voces, la plataforma permite a los usuarios configurar respuestas personalizadas, ajustar el tono de las respuestas y hacer que el chatbot se refiera a ellos por su nombre. Además, se ha mejorado la velocidad de respuesta y la capacidad de recordar conversaciones previas para facilitar interacciones continuas.

A pesar de que el modo de voz avanzado está disponible en más de 50 idiomas, por el momento no se ha lanzado en la Unión Europea, el Reino Unido, Suiza, Islandia, Noruega y Liechtenstein.

*La creación de este contenido contó con la asistencia de inteligencia artificial. La información fue proporcionada y revisada por un periodista para asegurar su precisión. El contenido no se generó automáticamente.